Парсинг сайтов — это процесс извлечения данных с веб-страниц, который позволяет автоматически собирать информацию из Интернета. Этот процесс играет важную роль в областях, связанных с анализом данных, мониторингом контента, SEO, исследованием рынка и многих других.

Несколько важных и тонких деталей, связанных с парсингом сайтов:

Инструменты и технологии

- HTML-парсеры, такие как Beautiful Soup (Python), позволяют анализировать структуру HTML-кода страницы.

- Web-драйверы, например Selenium, используются для имитации действий пользователя в браузере, что особенно полезно для работы со страницами, контент на которых генерируется динамически с помощью JavaScript.

- API веб-сайтов могут быть использованы для получения данных в структурированном формате, если таковой предоставляется самим веб-сайтом.

Юридические аспекты

- robots.txt. перед началом парсинга следует проверить файл robots.txt веб-сайта, чтобы убедиться, что веб-скрапинг разрешён.

- Авторские права и законы о конфиденциальности. Необходимо учитывать законодательство о защите авторских прав и данных.

Технические аспекты и этикет

- Избегайте чрезмерной нагрузки на серверы. Следует делать задержки между запросами, чтобы не создавать излишнюю нагрузку на инфраструктуру сайта.

- Изменение структуры сайта. Веб-сайты регулярно обновляют свою структуру, что может привести к необходимости корректировки парсера.

- Обработка JavaScript. Для сайтов, активно использующих JavaScript для генерации контента, может потребоваться использование инструментов, выполняющих JavaScript, таких как Selenium или Puppeteer.

Производительность и масштабирование

- Распределённый парсинг. Использование облачных сервисов и распределённых систем может помочь в масштабировании процесса парсинга, обрабатывая большие объёмы данных более эффективно.

- Кэширование и сохранение сессии. Это может сократить количество необходимых запросов к сайту и ускорить процесс парсинга.

Примеры использования

- Мониторинг цен. Автоматизация отслеживания изменений цен на товары в интернет-магазинах.

- Сбор новостей. Агрегация контента с нескольких новостных ресурсов для анализа трендов.

- SEO-анализ. Извлечение данных о ранжировании и ключевых словах с целью оптимизации сайта.

Парсинг сайтов — мощный инструмент, но с его помощью следует действовать ответственно, с уважением к правилам и ограничениям целевых ресурсов, а также с учётом возможных юридических последствий.

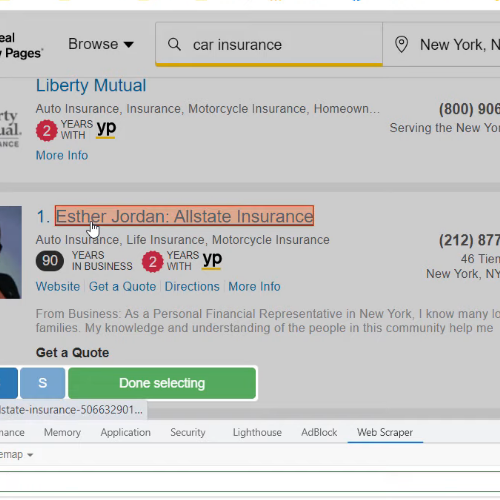

Посмотрите, как это работает

Посмотрите, как просто собирать информацию с сайта интернет-магазина с многоуровневыми вкладками товаров

Попробуйте бесплатно

После регистрации вы можете бесплатно попробовать сервис и сделать несколько тестовых скрапингов/парсингов страниц.

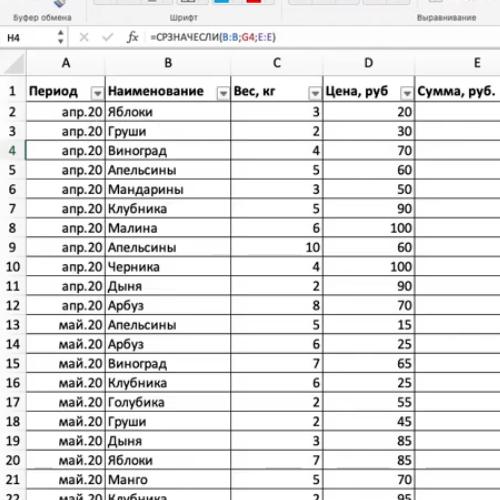

Сохранение данных в удобном формате

Извлеченные данны можно экспортировать в удобном вам формате: (Excel)CSV, JSON, SQL. Данные сразу готовы к работе с ними.

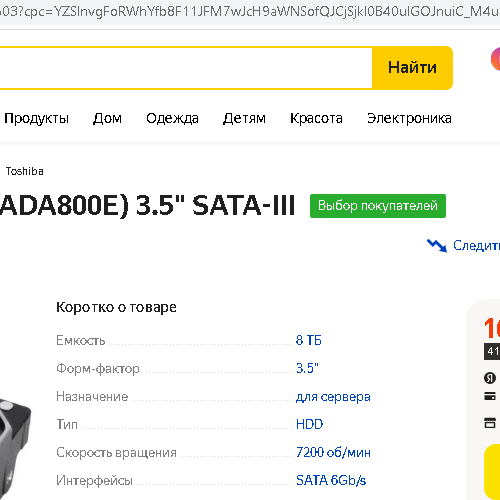

Извлечение данных из динамических страниц

Извлечение данных со станиц, генерирующихся динамически

Вы можете собирать абсолютно разный тип данных - текст, табличные данные, картинки, ссылки, и любые другие. Выборку данных можно настроить по любому параметру или селектору.

Для продвинутых пользователей: Используя язык JAVASCRIPT вы можете не только выбирать данные с сайта, но и сразу же их динамически преобразовывать, дополнять, изменять.

Полученную информацию перед выгрузкой можно модифицировать - уникализировать, перевести на другой язык, поменять формат.

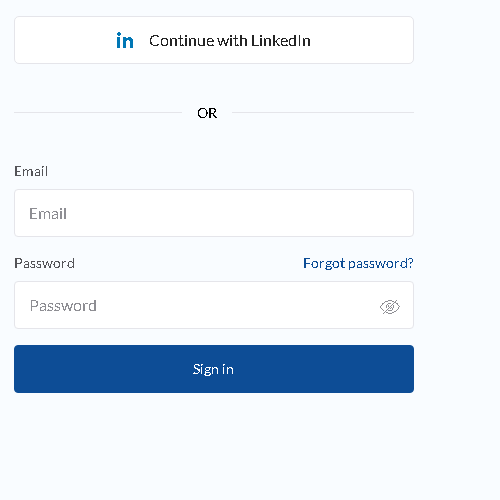

Парсинг данных с закрытых разделов

Если для сбора информации нужна авторизация под логином и паролем - парсер должен уметь автоматически логиниться на сайт, также, при необходимости и большей эффективности, парсер должен уметь применять куки, менять переменные браузера, менять ip адрес через прокси сервер.

Сайт, на котором хранится информация, не сможет отличить действия от человека.